论文信息 ¶

Frade, S., Pinheiro, A. P., Santi, A., & Raposo, A. (2021). Is second best good enough? An EEG study on the effects of word expectancy in sentence comprehension. Language, Cognition and Neuroscience, 37(2), 209-223. doi:10.1080/23273798.2021.1955140

论文原文 ¶

关键词 ¶

词汇预测;N400;ERP;句子理解;预期效应

摘要 ¶

当读者预期即将到来的单词时,句子的理解会被加快。尽管如此,仍然不确定是否只有最期望的单词被预期,如serial graded假说所假设的一样,还是说所有可能的单词都被预激活,如parallel probabilistic假说所提出的。为了测试这些不同的解释,作者比较了对预期单词和意外的单词的处理(使用次佳单词,即句子中第二期望的单词)。30个被试的结果显示,预期单词存在分级促进效应,以N400幅度为指标,最期望的单词负值最小,次佳单词的负值居中,意外的单词负值最大。N400后的正性分析没有显示出任何显著的影响。对最期望和次佳期望单词的促进效应表明,读者在句子理解过程中可以预先激活多个候选词。

引言 ¶

在某些情况下,先前的句子信息可以误导个体,例如在笑话或是semantic illusions中,但在大多数情况下,它有助于理解。许多证据都报告了预期词(例如,she cleaned the dirt from her “SHOES”)相比于意外的词(例如句法和语义上没问题,但不太可能出现的词,比如,She cleaned the dirt from her “BOAT”)的促进加工。具体就是,与意外单词相比,对预期单词来说,命名速度更快,阅读时间更短,对意外单词的反应时间也更短。大量ERP研究也显示,当句子上下文高度受限时,预期目标词的加工更容易,这反映在与意外/无效词相比,N400波幅降低(这里就是预测的benefits,但不知道找到了预测的costs没有)。尽管如此,这些预期进程如何实施仍存在争议。 一些研究表明,除了促进对预期单词的加工以外,与预期单词在语义上相关的意外单词与无关单词相比,诱发的N400减少,还有些研究发现当意外单词与预期单词有一些相同的拼写和语音特征时(如HOOK VS BOOK),诱发的N400也会减少(相较于其他的意外单词)。这些发现可以通过预期单词的预激活特征和意外但相似的单词的实际特征之间的重叠来解释,或者通过激活从预期单词扩散到相关单词,使得后者的便利加工。同时,这些促进效应还可能解释预期信息的轻松整合,因此,除了预测机制外,词汇的语义整合也可能起作用。 为了解决这个问题,有许多研究者又进行了pre-nominal的研究(这里又是介绍的经典的a/an实验,还有一些带性别标记的冠词、形容词以及一些量词的研究)。这些发现支持句子理解中的预测机制,因为它们表明读者在预期的单词出现之前就预测到了它们的关键特征(例如性别)。将预期词汇的促进加工归因于这些词的词汇语义整合比较容易的排他性的整合说法,无法适应这些促进效应。 最近研究还表明,当预测被违反时,在N400之后观察到的较晚的额叶正性,大约在单词开始后600-900ms(PNP),这种PNP通常是在对高限制的句子中出现的意外单词做出反应时诱发的(例如, he bought a necklace for her “collection"而最预期的单词是"birthday”),这种成分被认为反映了违反强预测时发生的附加操作,例如抑制预测的单词,还有种说法认为PNP对词汇整合困难很敏感,反映了对新的意外信息的同化,使其称为句子意义的更高水平表征。与N400相比,人们对PNP的功能意义及其引发它的条件的了解要少很多。(总的来说PNP不确定的太多了,语境的限制程度、弱预期的词还是完全意外的词、不同的实验有不同的结果) 当前的心理语言学理论强调预测作为一种促进句子理解的机制的重要性,但这种预测机制如何在语言处理的过程中展开仍然难以捉摸。 一些研究者认为,预测是通过一个连续的分级过程进行的,即作者最初预测最期望的单词,只有当这个预测被违反时,系统才可能更新对其他可能候选单词的预测。支持预测的特定性的发现,例如对带有性别标记的冠词/形容词的促进效应,指向高度特定的预激活(这里给的例子是“下雨了,最好带上“雨伞””,雨伞是最被预期的单词,但雨衣、雨鞋这种词在一定程度上也能被预期,但只有与雨伞搭配的冠词an有降低了的N400,说明其他的词没有被预期,但是!汉语中kwon的量词研究中量词部位是显示出了分级的N400的,这是否就和这个假设不匹配呢)。 还有种假说认为,预测是一种概率并行的过程,会同时考虑多种可能性,即读者在任何给定时间计算和预激活所以可能的候选词。这些候选词的激活程度将反应它们在句子上下文中的预期程度。以前的研究总是用完型填空概率代表一个词的期望程度,一个词的完型填空概率越高,该词的期望值就越大(除了完型填空概率外,还有entropy和word’s surprisal 见原文,大概也就是完型填空概率的变体),本研究使用的就是完型填空概率。一些研究显示了一个词的期望大小会调节促进效应的大小,相对于较高的完型概率的词而言,具有较低完型概率的词的N400幅度更强,这就为这种概率并行假说提供了依据。

目前研究 ¶

目前研究就是要阐明预测机制是如何展开的,具体来说就是比较这两种假说,哪种是正确的,到底我们只能预测最预期的单词,还是所有可能的候选单词都被预激活?为检验这两个假说,作者不仅探索了预期和意外单词的加工,还探讨了次佳候选词的加工,即句子中第二期望的词,例如,“狗狗整个下午都在啃—-”,”骨头“就是预期词,而”鞋“就是次佳候选词,而”眼镜“则是完全无关的意外词,这三个词都是看似合理的填充词,只是与不同的预期水平有关(可是,这个次佳候选词和完型填空概率第二高的词有什么区别呢,这类实验之前不是已经做过很多了吗)。最期待的词,如上文的”骨头“总体上是中等预期的(因为使用的句子不是强约束的句子,否则的话不会产生超过一个预期的候选词),而次佳的词是弱预期的,以前的研究表明N400幅度的调制指示单词的期望,所以中等和弱期望的词比高度期望的单词产生更大的N400幅度。以前的研究的预期效果都是由句子的上下文驱动的(例如比较,他儿子偷了一辆”车“和这辆”车“没什么问题,中的”车“,车的预期程度是由句子操控的,一个是中等限制句子,一个是低限制句子),这些句子的上下文可以是高度限制也可以没那么限制。但是,一个不是最受期待的词是否以及何时导致促进效应,还有待研究。 检查次佳单词是如何加工的能够帮助我们分清上面那两个假说。根据假说1,次佳单词不应存在促进效应,因为只有最预期的单词可以被预激活,因此相较于最预期的单词,次佳单词的N400的幅度会更负,而次佳单词与意外单词有相似的N400幅度,因为两者都没有被预激活。 而根据假说2,所有可能的候选词都是预激活的。次佳单词也应该被促进,但次佳单词的可能性比最预期的单词小,这个效果应该比最预期的单词小,具体来说,N400幅度应反应关键词的预期水平,那么N400的幅度应该是分级的,具体就是最预期的单词到次佳单词到意外单词,幅度逐级增加。 最后,作者对PNP进行了探索性分析,因为大多数PNP都是在强约束句子下有的,这里就探索中等限制的句子是否能引起这种PNP,很少有研究观察到在弱约束或者中等约束条件下的PNP效应。因此,句子的约束程度是否会影响这一成分的出现还是个未知数。

当前实验 ¶

- 被试 30个大学生,葡语母语者,右撇子,没有神经损伤或阅读障碍病史。

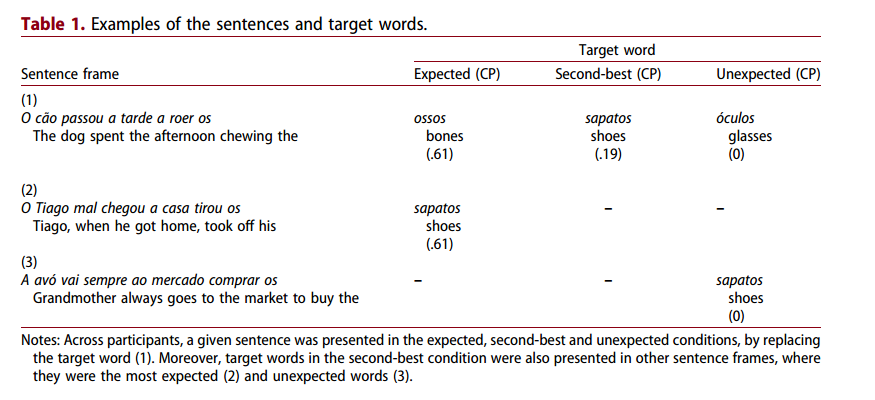

- 实验材料 从之前已经进行果完型填空测试的807个句子中选了270个中等限制的句子。其中涉及完型填空概率(CP)程序的具体操作这里就不赘述。这些句子中,有三分之一的句子与最期望的单词(CP=.61)、次佳单词(CP=.19)或者意外单词(CP=0)一起呈现。为了避免重复,每个被试只会看见一次某个句子。为了确保在三个实验条件下呈现相同的目标词,90个次佳单词也会被呈现在其他句子语境中,其中,它们是最期望的词以及意外词(那这个实验材料未免太难设计了吧)如下图所示

为了确保每个被试只看到每个句子和目标单词一次,作者创建了四个列表,每个列表包含45个句子,每个被试只用看一个列表即可。

- 实验程序 首先是屏幕中央500ms的十字,然后逐词呈现该句子,每个单词持续200ms,以及一个300ms 的间隔(不是还要看PNP吗,这里才500ms),句子呈现顺序是伪随机的,保证每个条件的句子总是少于三个连续出现,为了保证专心阅读,被试还要在关键词出现后1000ms判断前一句是否出现了probe word,一半的probe word是从句子里随机选择的,还有一半是从其他句子里选出来的,一定是实词,但绝不是最后的词,也就是关键词。 被试被要求尽量避免眨眼和身体运动,在实验之前,9次练习。主要实验环节分为了五个区块,每个区块间有短暂的休息。脑电结束之后,被试还为之前呈现的每个句子的合适程度打分,五分制。

- 行为学数据分析 识别任务的结果在两个混合效应模型中进行了分析。Rstudio中的LME4程序包,使用广义线性模型分析正确反应的比例,以及用线性混合效应模型分析正确实验的反应时(RT),高于或低于平均值2.5个标准差的RT被排除在外。每个模型的固定因素是目标词的类型(最预期、次佳、意外)、被试以及被包含为随机效应的项目。还使用了backward difference contrast用于目标词因素(这个方法还不太懂是啥)。 为了考察句子的可信程度,这里还计算了一个累计的link混合效应模型。这里也用到了这个backward difference,但具体是做什么的,我目前还不清楚。

- EEG记录和分析 有64个电极,其他的设置基本和以往的实验差不多,包括以乳突为参考、放在眼睛附近检测眼球运动、后面还要排除artefact这些操作等。使用EEGLAB及插件ERPlab对数据进行预处理。预处理的具体步骤见原文。为每个目标单词创建从单词起始之前的200ms到单词开始之后的1000ms的时段,使用单词开始前的-200ms到0ms进行基线修正。 仍然使用Rstudio里的lme4程序包对每个特定的脑区的每个成分(也就是N400和PNP了吧,没别的)进行单独的线性混合模型。 对于N400成分,因变量是三个ROI中目标词呈现后300-500ms之间的单次试验的幅度,三个ROI分别是额区,10个电极,中央区,10个电极,顶区,8个电极。模型中的固定因素是目标词类型(最预期、次佳、意外)、ROI(大概就是前、中、后)以及它们的交互作用,被试和项目都被纳入随机效应。这里再次使用了backward difference对比用于目标单词的因子,其中次佳和意外比较,预期和次佳比较。 而对于PNP成分,因变量是三个ROI在目标词出现后600-900ms之间的单次试验幅度,三个ROI分别是左前,5个电极,中线前,2个电极,右前,5个电极,这些也是基于先前的研究定的。线性混合模型的固定因素以及那个backward difference对比和上面的N400成分里的设置一样,这里就不重复写。

结果 ¶

- probe word再认任务 理解任务的总体准确率是0.98(SD=0.03),表明被试有专心阅读句子,准确率和反应时的两个模型中,两个对比结果均不显著。

- 句子的合理性 结果显示,所有句子总体上都是合理的,在5分制的情况下平均分高于3分,其中分数最预期的词>次佳词>意外词。在这个得分模型中,预期单词条件和意外单词条件之间存在显著差异,表明意外词填充的句子的合理性得分要低于预期词填充的句子。此外,预期单词和次佳单词填充的句子之间的得分差异也是显著的。

- ERP结果 对总体平均的ERP波形的视觉检查发现,与之前使用逐词视觉呈现范式进行的句子理解研究中观察到的模式相似。在所有条件下,目标词都会引起一个最初的正性峰值(P1),一个负性峰值(N1),随后是一个大约200ms左右的在头皮广泛分布的正向峰值(P2)。这些成分之后是一个负波,峰值在300-500ms(N400),在中央-顶叶位置最大。在所有情况下,N400之后,ERP都开始变得更加正向,视觉检查显示对意外单词的正性反应略有增加,特别是在左前电极上。 N400成分:在N400幅度这个模型中,显示次佳词和最预期的词的N400幅度存在显著差异p<.001,表明次佳词比最预期词诱发的N400更负,此外,次佳词和意外词之间的差异也很显著p=.01,意外单词的N400比次佳单词更负。没有显示出其他显著的效应。 PNP成分:在这个模型中,没有任何效应显著(那看来中等限制的语境的确难以诱发PNP吗?)

讨论 ¶

在中等限制的句子中,次佳单词的加工与N400有关,次佳词的N400幅度既不同于预期的单词,也不同于意外的词,它介于二者之间。这一结果表明,这种促进效应延伸到了中等完型填空概率的预期单词上,即使这些单词出现在了存在另一个更期望的单词的上下文中。因此,降低的N400幅度并不是最期望的单词所独有的(这就验证假说2了),而当单词不被先前的句子上下文支持时,即意外单词的情况,需要更多努力来处理单词,也就反映为更负的N400幅度。 而在300-500ms内,次佳词的N400波幅高于最期望词,这表明次佳词的加工并没有促进到和最预期词相同的程度,即使次佳词也是预期的候选词。这个差异与之前的研究一致,这些研究表明,单词预期会调节N400幅度:一个给定的单词在句子上下文中被预期的越多,N400幅度越小。研究者的结果表明,在中等限制的句子中,存在着一种可以延伸到其他可预期词的促进效应。 对于次佳单词和最预期单词,N400幅度的降低可能至少部分与句子阅读过程中这些单词的预激活有关,尽管这个数据集中在词首之后的脑电效应上,但先前的研究一直表明,在句子理解中能够预激活特定的单词或单词特征。 有的人可能认为目标词处的N400效应是因为整合引起的,这时候之前测的句子的合理性就起作用了(这个句子合理性分数就可以反映词是否能够很好地嵌入到句子里),最预期词和次佳词的句子合理性得分都是没有显著差异的,但N400却有差异,所以发现的效应在一定程度上是和词汇的预激活有关的。 本实验观察到的这种分级效应是和假说2,也就是parallel probabilistic假说一致的。一些学者认为完型填空概率在低限制的语境下可能不能反映被试对词汇的预期,因为还没有反应时等数据,就只有一个单单的填空题,未来的研究可以使用在多种反应范式中获得的完型填空概率或者其他的措施(也就是之前提到的什么word‘s suprisal以及词嫡等)来比较单词的加工。 同时,结果还挑战了之前的发现,即在高限制句中,预激活的表征是高度特定的。如果预激活是高度特定的,那么就只有与最期望的词具有相同语义特征的词才会发生促进作用。本材料中,一些最预期词和次佳词之间是语义不相关的,例如“奶奶照顾她的—-”,最预期词是孙女,而第二预期词是花,这两个没有什么语义共同点,因此,数据表明了这种预激活并不是高度特定的,而且似乎最好是从单词的预期角度来解释(但是这里作者也没有谈到这种语义不相干的情况的比例,万一比例不算太大,那不也还是有可能是其他的情况导致的吗)。 尽管作者认为预测机制在N400效应中起主导作用,但一些作者认为N400很复杂,既反映了词汇特征的提取,也反应了词汇整合到句子中的认知需要(那不就还是整合+预测的观点么)。根据这一观点,与意外词相比,最预期词和次佳词的促进效应可能是由于这些词的促进提取或者简化的整合。似乎这样也可以说通:最预期词的反应的N400波幅降低反映了这些词的预激活和更容易整合,而对于次佳词的促进效应就只是更容易的整合而没有预测的作用,虽然也能说通但作者认为不太可能。一个就是因为所有目标词都易整合,因为就算是意外词,句子的合理分数也高于平均得分。第二就是因为最期望词和次佳词的N400降低都在同一个时间窗口,表明潜在过程可能是相同的(第二点很有道理,但是第一点,那个句子的合理程度得分的作用真的有这么大吗?)。因此还是支持假说2。 接下来讨论PNP。该研究中没有显示出PNP效应。也许就是语境限制程度的影响,见前文。以前都是强限制语境下的,而当前研究是中等限制(这里也就提到了,所谓的强限制就是完型填空概率高,比如这里的例子就是>80%),因此也就和之前的PNP说法一致,即只有当意外词被整合到高限制语境下才能观察到PNP,同时还有研究显示,只有与最预期词无关(大概是语义上无关)的意外词才会引发PNP。在本研究中并没有控制预期词和意外词语义是否相关,因此有的相关有的不相干。同时,PNP幅度也会受到任务要求的影响。与被动的阅读任务相比,在明确指示让被试预测即将到来的单词的任务中由意外单词引发的PNP具有更正的幅度(而本实验就是属于前者的,所以没诱发出来大概也正常),因此表明了这种PNP并不是句子理解的关键所在。 作者还对其选择的统计模型进行了分析,作者相信其模型是适用的,报道是可靠的(不过话说这个真的需要报告吗,第一次见) 但这些都是在实验室环境下做的,所有材料都是中等限制的,没有反映出自然阅读情景中会发生什么。但种种证据表明,这种预测影响在更自然的环境中也可以复制。