文献:Li, Z., Hong, B., Wang, D., Nolte, G., Engel, A. K., & Zhang, D. (2022). Speaker–listener neural coupling reveals a right-lateralized mechanism for non-native speech-in-noise comprehension. Cerebral Cortex. https://doi.org/10.1093/cercor/bhac302

论文原文 ¶

1. 研究背景及本研究 ¶

随着全球化趋势,越来越多的人学习非母语语言,但非母语语言的使用面临很多挑战,尤其是背景噪音的盛行对非母语语言理解造成很大的影响,人们如何适应理解噪音中的非母语语音信息的神经机制仍然不清楚。

之前神经成像技术的研究表明听觉机制(auditory mechanism)和感觉运动机制(sensorimotor mechanism)都有助于噪声中母语语音的理解(e.g. Du et al. 2014; Alain et al. 2018; Li et al. 2021)。听觉机制基于听觉特征抑制对要忽略的噪声的编码来实现对要关注的语音流的有效处理;感觉运动机制通过模拟与感知语音相关的发音姿势来补偿被噪声污染的语音信息(Hickok et al. 2011; Parrell & Niziolek 2021; Raharjo et al. 2021),但不能把这两种机制直接应用于非母语语言理解中,因为就听觉机制而言噪声中母语语音的加工依赖于左侧化的脑区(Vigneau et al. 2006; Scott et al. 2009; Corballis 2015; Vander Ghinst et al. 2016),噪声中非母语语音的理解可能采用不同的听觉处理机制,因为非母语语音的处理主要依赖于右侧化脑区,包括右侧颞上回(STG)、右侧颞中回(MTG)等 (Archila-Suerte et al. 2013; Qi et al. 2019; Gao et al. 2020; Cotosck et al. 2021; Yi et al. 2021),左侧脑区是否通过听觉机制参与降低噪音尚不清楚。并且就感觉运动机制而言,听觉经验和相应的语音产出经验之间的强关联是所感知的语音信息稳定的感觉运动表征的先决条件(Hickok & Poeppel 2007; Sehm et al. 2013; Du et al. 2014; Alain et al. 2018),因此非母语听者(尤其是那些在语言习得关键期之后习得非母语语言的人)是否从这种机制中受益还不清楚。而且,目前的研究主要集中在噪声下对孤立、简单语言材料的神经反应(Coulter et al. 2021; Grant et al. 2022),很少有对噪声环境下连续自然语音理解的探讨。

一方面无论是母语还是非母语的连续自然语言,都包含比孤立和简化的语音材料更丰富的动态时频信息,因此可能对应更真实和更广泛的神经活动 (Huk et al. 2018; Sonkusare et al. 2019; Li et al. 2022);另一方面,连续的自然语音可以为听者提供语境信息,以便恢复被噪声污染的语音中丢失的信息,从而促进对噪声中语音的理解,并且这些语境信息对非母语者的帮助更大(Bradlow & Alexander 2007; Song & Iverson 2018; Borghini & Hazan 2020)。听觉和感觉运动机制都可以受益于丰富的动态时频信息和语境信息,因此有必要进一步研究非母语听者如何利用连续的自然语言材料进行有效的言语理解。

近来新出现的“interbrain”方法也适合自然语音材料的研究,传统的“single-brain”方法侧重于听者的神经活动对外部语音刺激的耦合(反应),而“interbrain”方法强调听者的神经活动和说话者的神经活动之间的耦合(Hasson et al. 2012; Czeszumski et al. 2020; Kelsen et al. 2022),避免了从自然语音声学中定义和提取“事件”信息的困难。以说话者的神经活动作为无噪声参考,听者-说话者神经耦合的空间模式有助于揭示听觉和感觉运动机制对理解噪音中的非母语语音的作用。

本研究采用连续自然语言叙述和“interbrain”方法来研究听者如何在噪音中理解非母语语言的神经机制。招募了15个在语言习得关键期以后学习中文的韩国被试,让被试听6个以汉语为母语的人录制的汉语叙述。收集讲话者和听话者两方的功能性近红外光谱(fNIRS)信号,相同的通道设置覆盖了双侧分布的典型语音相关脑区。以4个噪声水平的分级操纵噪声,以揭示听者如何适应不同的噪声水平。如果听者的相应fNIRS通道和说话者的fNIRS信号之间的神经耦合与听者在至少一种噪声水平下的个体化理解表现相关,则听者的这个大脑区域将被认为与非母语噪声中的语音理解功能相关。如果涉及听者的言语感觉运动整合相关脑区,那么就支持感觉运动机制在非母语语音处理中的作用;并且所涉及的大脑区域的偏侧化将进一步揭示非母语语音处理可能的特异性:左偏侧化处理将意味着依赖于听者的母语语音处理模块来解决非母语语音的噪声,而右偏侧化处理将表明噪声中非母语语音处理的独特机制。

2. 方法 ¶

2.1 参与者 ¶

15名清华大学的韩语母语者学生参与本研究,年龄18至24岁,其中6名男性,9名女性。这些参与者都是在12岁之后学习汉语的,远超语言学习的关键期,学习的时间从4至9年不等,他们都通过了汉语水平考试六级,表明他们能够流利的与中国人交流。

2.2 刺激 ¶

用之前(Li et al. 2021)研究中的32个叙述性语音,都是根据国家普通话水平测试改编的日常话题,持续时间为85-90s,这些叙述是由6名受过清华大学播音主持专业培训汉语母语者的大学生(3名男性,3名女性;年龄从21岁到25岁不等),叙述的内容被试并不熟悉。讲话者的fNIRS数据是在讲话期间收集的。在播放给听众之前,这些音频以4种不同的噪声水平被处理成4个版本:无噪音(NN)和三个信噪比水平分别为2, −6, 和 − 9 dB的噪音水平。通过在原始音频中添加白噪声来控制噪声水平,对于每个选定的叙事,有4个关于叙事细节和主题的四选问题,例如,在叙述性音频之后的一个问题是“说话人最欣赏的知名人物的职业是什么?“四个选线分别是1.记者, 2.心理医生, 3.作家, 4.历史学家。每个听众对每个噪音水平的理解表现为在相应噪音水平下所有8个叙述的平均准确性。

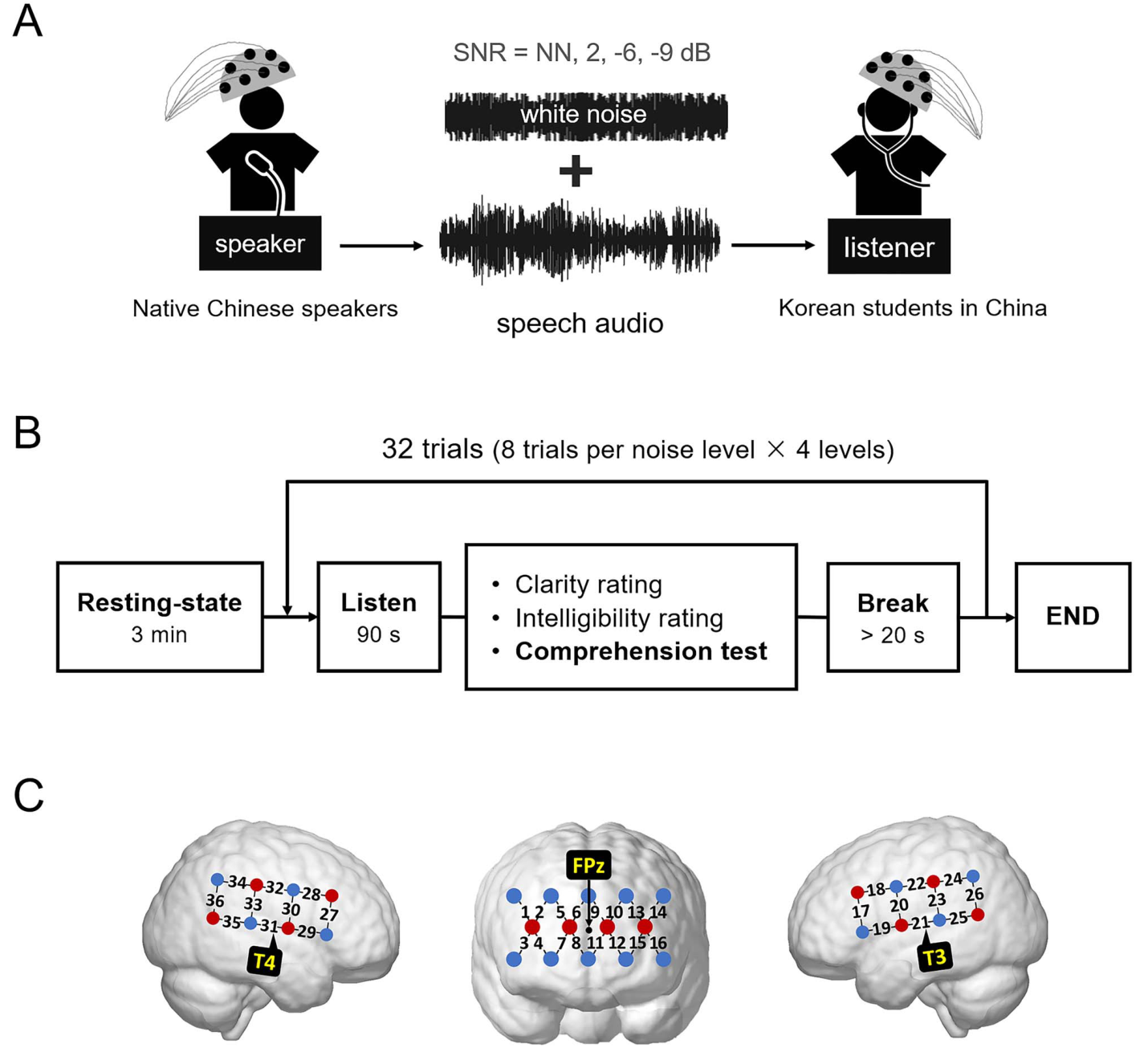

2.3 实验流程 ¶

被试在32个trial中听32段不同噪音水平的中文叙述性音频,在每个trail中被试都以某一种噪音水平听一段叙述性音频,然后在7点Likert量表上对听到音频的清晰度和可懂度进行评分,并完成关于叙述性音频的四项选择问题,然后被试至少休息20s再按空格键继续下一个trial。叙述性音频和他们对应的噪音水平是完全随机的,并告知被试音频是提前录制好的。在被试开始实验之前会让他们保持静息状态即闭目放松保持3分钟,之后会给他们呈现一个另外的−2 dB 信噪比的音频以适应流程。

3. 结果 ¶

3.1 行为结果 ¶

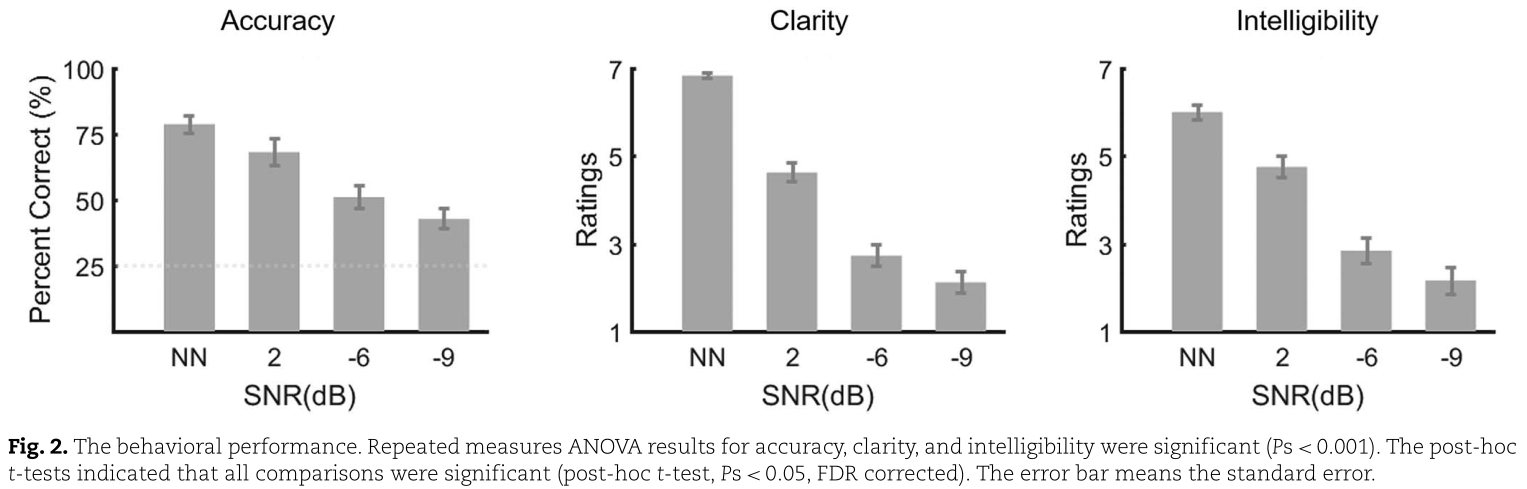

在噪声水平为NN、-2 d B、-6 dB和-9 dB时,言语理解得分分别为78.75±3.29%、68.13±5.15%、51.04±4.22%和42.71±3.74%(平均±标准误差),即信噪比水平越低得分越低。不同信噪比得分具有显著性差异,并且即使信噪比在-6和-9dB,理解分数也明显高于随机水平25%。在4个噪声水平下,清晰度得分分别为6.83±0.05、4.63±0.21、2.73±0.24和2.12±0.23(平均±标准误差);可懂度得分分别为6.00±0.17、4.75±0.25、2.84±0.29和2.16±0.30(平均±标准误差),清晰度和可懂度的主观评级也显示了噪声水平的显著影响。虽然非母语听众自我报告表明,当噪音更强时清晰度和可懂度评级急剧下降,但他们仍然达到了中等水平的理解能力。

3.2 说话者和听者之间的神经耦合 ¶

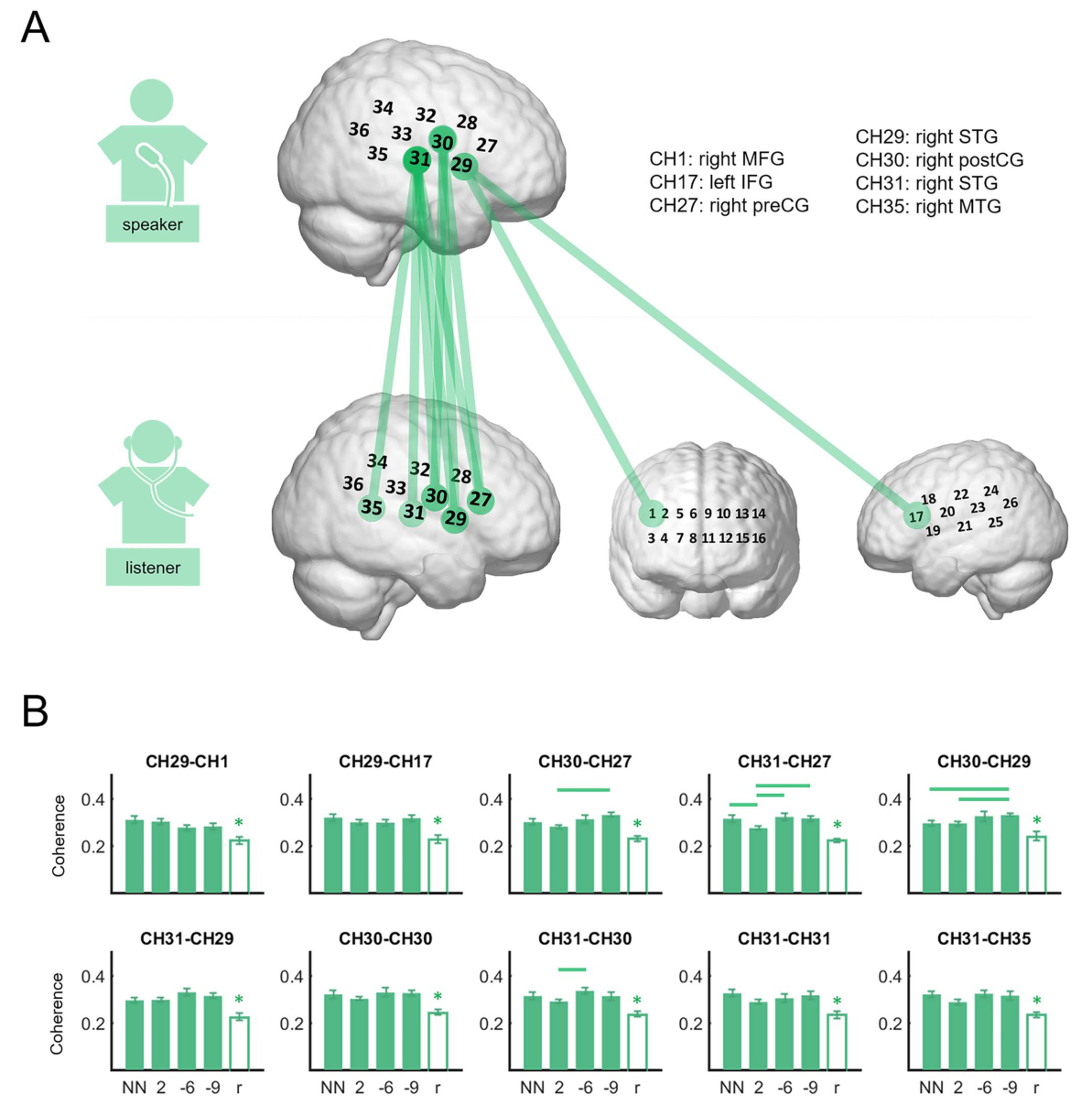

神经耦合的重复方差揭示了10个具有显著任务条件效应的通道组合,通道组合覆盖了听者的右MFG(CH1)、左IFG (CH17)、右侧前CG(CH27)、右侧STG(CH29/31)、右侧后CG(CH30)和右侧MTG(CH35),在说话者一侧,相关的大脑区域更受限制,集中在右侧STG (CH29/31)和右侧后CG (CH30)。这些确定的通道组合,在4种噪声水平下都观察到了比静息状态条件下更强的说话者-听者神经耦合。这10个通道组合中,有4个通道组合显示了噪声水平之间的显著差异。分别是CH30-CH27,2 dB处的神经耦合低于-9 dB处的神经耦合;对于CH31-CH27,2 dB处的神经耦合低于其它3个水平的神经耦合;对于CH30-CH29,耦合度呈上升趋势,NN和2 dB处的耦合度低于-9 dB,对于CH31-CH30,-6 dB耦合低于2 dB处的耦合。

3.3 非母语和母语听者对说话者的神经耦合比较 ¶

研究比较了之前Li et al. 2021研究中母语听者的耦合机制,发现噪声中非母语语音处理的神经一致性通常比母语的高,分析表明,在噪声水平为-9 dB时,非母语与母语的差异显著(P = 0.037),而在其他3个噪声水平差异不显著(Ps > 0.05)。

3.4 说话者-听者神经耦合的行为相关性 ¶

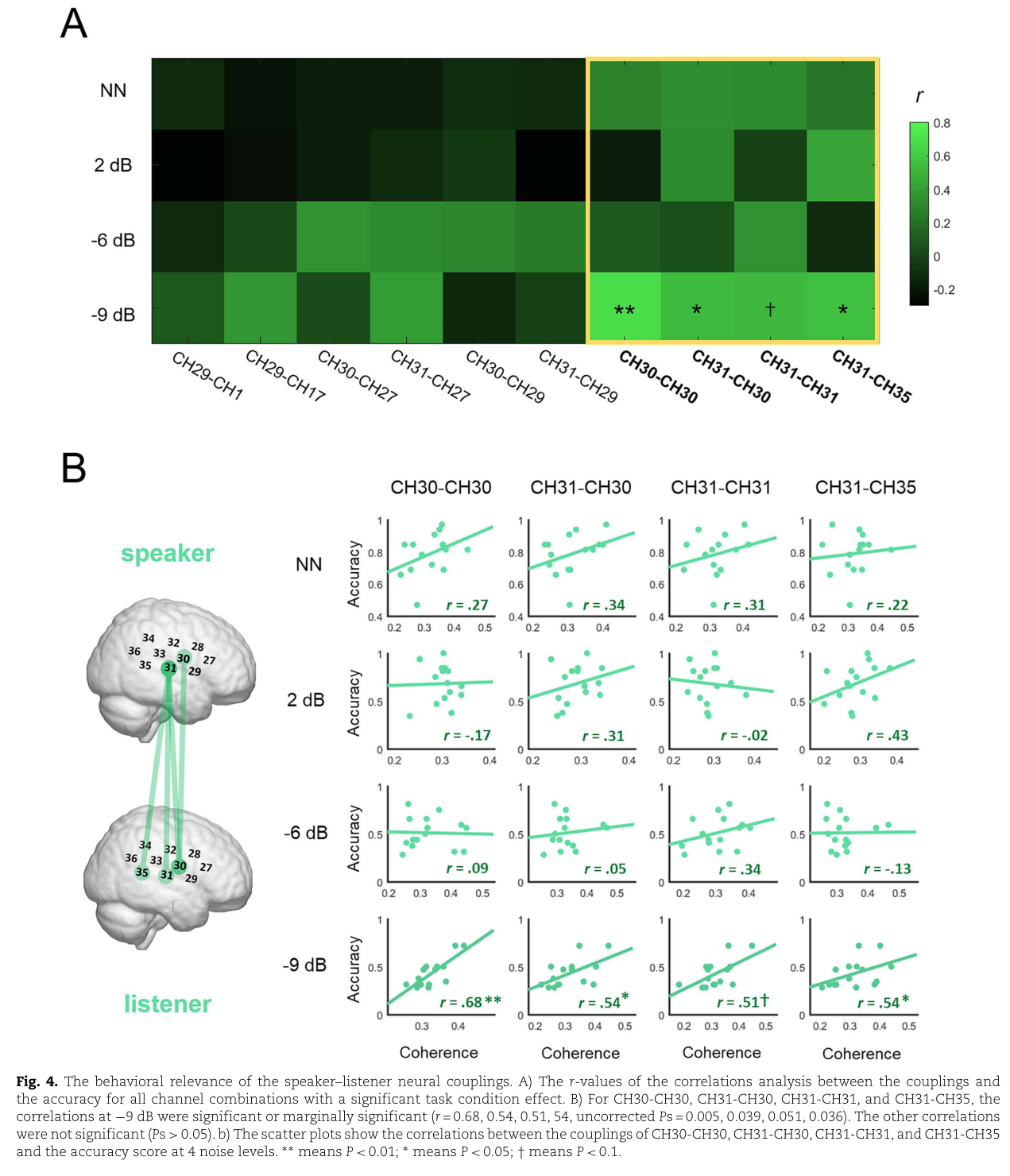

语音理解能力与神经耦合之间的相关性分析揭示了与噪声语音理解功能相关的脑区,图4A显示了在所有4种噪声水平下具有显著任务条件效应的通道组合的相关r值。只有说话者的右侧中央后回、右侧颞上回和听者的右侧中央后回(CH30-CH30,CH31-CH30)、说话者的右侧颞上回、听者的右侧颞上回和右侧颞中回 (CH31-CH31,CH31-CH35)之间的神经耦合与-9 dB噪声水平下的理解表现正相关。下图4B展示了具有显著行为相关性的4个通道组合的相关结果和大脑定位的散点图,进一步比较了每个通道组合的所有4个噪声水平之间的相关性,对于CH30-CH30,-9 dB处的相关性明显大于2和-6 dB处的相关性,对于CH31-CH31,-9 dB处的相关性大于2 dB处的相关性,对于CH31-CH35,-9 dB处的相关性大于-6 dB处的相关性。

4. 讨论 ¶

对比之前的母语研究,本研究发现人们在噪声条件下对母语的加工主要依靠左侧额下回。左侧额下回处理的是较高层级的、有含义的言语信息,如语义等,而中央后回处理的言语信息主要位于语音水平。这表明,由于受到噪声的干扰和自身语言经验的局限,人们在噪声条件下理解非母语语音时只能依赖于声学信息的加工和较低层级言语信息的感觉运动加工,而较难对较高层级的言语信息进行有效的弥补,因此表现出了相对于母语的劣势。尽管如此,本研究揭示了非母语噪声中语音理解右侧偏化的听觉和感觉运动加工的混合机制。

与之前在母语听者中的研究相比发现听者-说话者的神经耦合在相同的频率范围内,表明听者-说话者交流有一个共同的频谱机制。但是,听者-说者神经耦合的空间模式是完全不同的。在母语听者中神经耦合的脑区主要在左IFG和右MTG/AG,而非母语听众包括延伸到前部的额外的右侧大脑区域,支持了右侧化区域对于非母语噪声中语音处理的特异性。

同时实验设计也有待改进,比如可能可以通过让同样一群被试分别在噪声中听他们的母语和非母语语言以排除人口统计信息的影响的被试间设计,以评估右侧化机制对非母语噪音语音理解的特异性。其次,实时通信可以通过增强说话者和听者之间的共享表征和说话者更主动的预测来进一步促进对噪声中语音的理解,从而导致更广泛和更强的神经耦合(Jiang et al. 2021; Kelsen et al. 2022)。